Web Scraping adalah alat yang secara khusus dikembangkan untuk mengekstraksi informasi dari berbagai situs. Mereka juga dikenal sebagai alat web panen atau alat web ekstraksi data. Alat ini berguna bagi siapa saja yang mencoba untuk mengumpulkan beberapa bentuk data dari Internet. Web Scraping adalah teknik entri data baru yang tidak memerlukan mengetik berulang atau copy-paste.

Software ini mencari data baru secara manual atau secara otomatis , mengambil data baru atau diperbarui dan menyimpannya untuk memudahkan akses Anda. Misalnya, satu dapat mengumpulkan info tentang produk dan harga mereka dari Amazon menggunakan alat menggores. Dalam posting ini, kita akan menemukan daftar kasus penggunaan web dan 10 web untuk mengumpulkan informasi, dengan nol coding.

Gunakan Kasus Web Scraping

Web Scraping dapat digunakan untuk tujuan terbatas dalam berbagai skenario tapi kami akan pergi dengan beberapa kasus penggunaan umum yang berlaku untuk pengguna umum.

Kumpulkan Data untuk Riset Pasar

alat web menggores dapat membantu Anda tetap mengikuti di mana perusahaan atau industri sedang menuju dalam enam bulan ke depan, melayani sebagai alat yang ampuh untuk riset pasar. Alat dapat fetch data dari penyedia analisis beberapa data dan perusahaan riset pasar, dan mengkonsolidasikan mereka ke dalam satu tempat untuk referensi yang mudah dan analisis.

Ekstrak kontak

Alat-alat ini juga dapat digunakan untuk mengambil data seperti email dan nomor telepon dari berbagai website, sehingga memungkinkan untuk memiliki daftar pemasok, produsen dan orang lain dari kepentingan bisnis atau perusahaan, di samping alamat kontak masing-masing.

Download Solusi dari StackOverflow

Menggunakan alat web menggores, kita juga dapat men-download solusi untuk membaca offline atau penyimpanan dengan mengumpulkan data dari beberapa situs (termasuk StackOverflow dan P & website A). Hal ini akan mengurangi ketergantungan pada koneksi internet aktif sebagai sumber daya yang tersedia terlepas dari ketersediaan akses internet.

Carilah Jobs atau Calon

Untuk personil yang secara aktif mencari kandidat lebih untuk bergabung dengan tim mereka, atau untuk pencari kerja yang mencari peran atau pekerjaan lowongan tertentu, alat ini juga bekerja keras untuk dengan mudah mengambil data berdasarkan filter, dan untuk mengambil data yang efektif tanpa pencarian manual.

Harga lagu dari Beberapa Pasar

Jika Anda ke belanja online dan senang untuk aktif melacak harga dari produk yang Anda cari di beberapa pasar dan toko online, maka Anda pasti membutuhkan web scraping

10 Web Scraping Terbaik

Mari kita lihat pada 10 alat Scraping web terbaik yang tersedia. Beberapa dari mereka adalah gratis, beberapa dari mereka memiliki periode percobaan dan rencana premium.

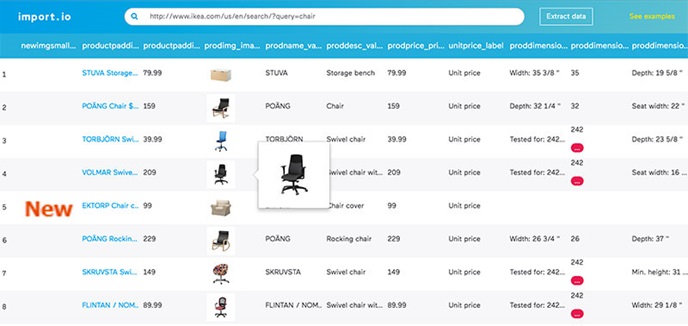

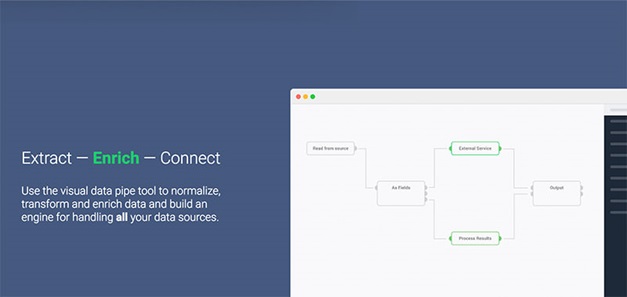

Import.io menawarkan pembangun untuk membentuk dataset Anda sendiri dengan hanya mengimpor data dari halaman web tertentu dan mengekspor data ke CSV. Anda dapat dengan mudah mengikis ribuan halaman web dalam hitungan menit tanpa menulis satu baris kode dan membangun 1000 + API berdasarkan kebutuhan Anda .

Import.io menggunakan teknologi mutakhir untuk mengambil jutaan data setiap hari, yang bisnis dapat memanfaatkan untuk biaya kecil. Seiring dengan alat web, itu juga menawarkan aplikasi gratis untuk Windows, Mac OS X dan Linux untuk membangun extractors data dan crawler, download data dan sinkronisasi dengan akun online.

Webhose.io menyediakan akses langsung ke real-time dan data terstruktur dari ribuan sumber online. Web scraper mendukung penggalian data web di lebih dari 240 bahasa dan menyimpan data output dalam berbagai format termasuk XML, JSON dan RSS .

Webhose.io adalah aplikasi web berbasis browser yang menggunakan data yang eksklusif secara teknologi dalam jumlah besar dari beberapa saluran dalam API tunggal. Ia menawarkan rencana bebas untuk membuat 1.000 permintaan / bulan, dan rencana premium $ 50 / mth untuk 5000 permintaan / bulan.

CloudScrape mendukung pengumpulan data dari situs web apapun dan tidak memerlukan download seperti Webhose. Ini menyediakan editor berbasis browser untuk mengatur crawler dan ekstrak data secara real-time. Anda dapat menyimpan data yang dikumpulkan pada platform cloud seperti Google Drive dan Box.net atau ekspor sebagai CSV atau JSON.

CloudScrape juga mendukung akses data anonim dengan menawarkan satu set server proxy untuk menyembunyikan identitas Anda. CloudScrape menyimpan data Anda pada server selama 2 minggu sebelum mengarsipkannya. Web scraper menawarkan 20 jam web scraping gratis dan akan dikenakan biaya $ 29 per bulan.

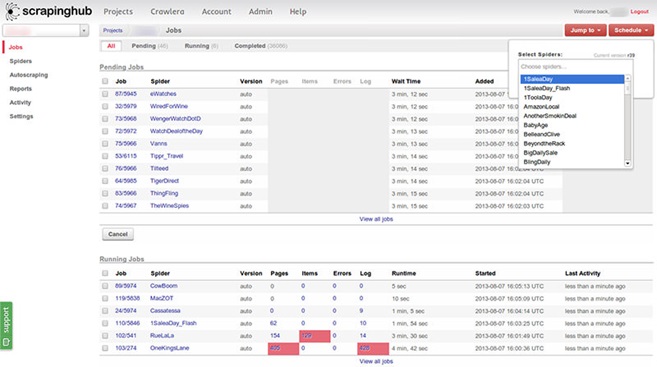

Scrapinghub adalah alat ekstraksi data berbasis cloud yang membantu ribuan pengembang untuk mengambil data berharga. Scrapinghub menggunakan Crawlera, rotator proxy yang cerdas yang mendukung melewati bot untuk menjelajah situs besar atau bot yang dilindungi dengan mudah.

Scrapinghub mengubah seluruh halaman web ke dalam konten terorganisir. Tim ahli yang tersedia untuk membantu dalam hal pembangun crawl . Ini adalah dasar rencana gratis memberikan Anda akses ke 1 dan rencana premi sebesar $ 25 per bulan.

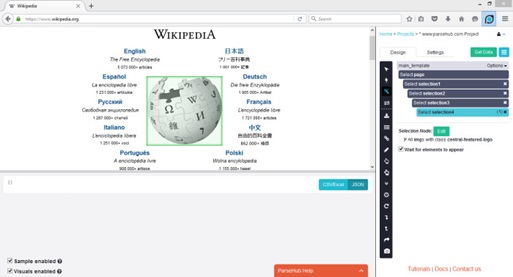

ParseHub dibangun untuk menjelajah situs tunggal dan beberapa dengan dukungan untuk JavaScript, AJAX, sesi, cookies dan pengalihan. Aplikasi ini menggunakan teknologi mesin belajar untuk mengenali dokumen yang paling rumit di web dan menghasilkan file output berdasarkan format data yang diperlukan.

ParseHub, selain dari aplikasi web, juga tersedia sebagai aplikasi desktop gratis untuk Windows, Mac OS X dan Linux yang menawarkan rencana dasar gratis yang mencakup 5 proye. Layanan ini menawarkan rencana premium sebesar $ 89 per bulan dengan dukungan untuk 20 proyek dan 10.000 halaman web.

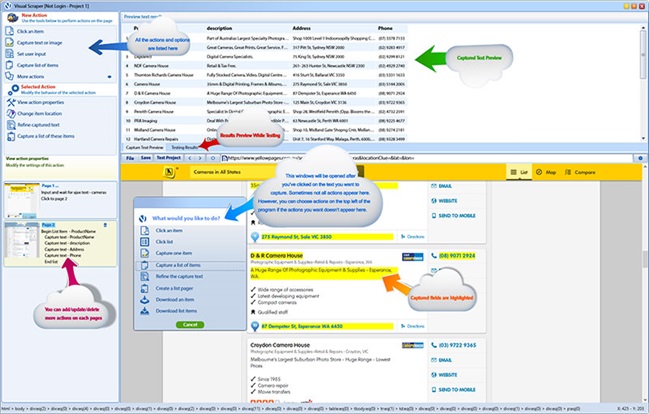

VisualScraper adalah web software ekstraksi data lain, yang dapat digunakan untuk mengumpulkan informasi dari web. Perangkat lunak ini membantu Anda mengambil data dari beberapa halaman web dan mengambil hasil secara real-time. Selain itu, Anda dapat mengekspor dalam berbagai format seperti CSV, XML, JSON dan SQL .

Anda dapat dengan mudah mengumpulkan dan mengelola data web dengan sederhana dan klik antarmuk . VisualScraper datang dalam rencana gratis serta premium mulai dari $ 49 per bulan dengan akses ke 100K + halaman.Ini adalah aplikasi gratis, mirip dengan Parsehub, tersedia untuk Windows dengan C paket tambahan ++.

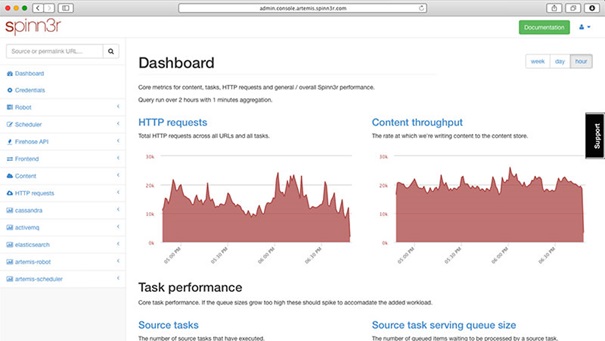

Spinn3r memungkinkan Anda untuk mengambil seluruh data dari blog, berita & media sosial situs dan RSS & ATOM feed. Spinn3r didistribusikan dengan API pemadam kebakaran yang mengelola 95% dari pekerjaan pengindeksan. Ini menawarkan perlindungan spam canggih, yang menghilangkan spam dan bahasa yang tidak pantas digunakan, sehingga meningkatkan keamanan data.

Spinn3r indeks konten mirip dengan Google dan menyimpan data yang diambil dalam file JSON. Web scraper terus scan web dan menemukan pembaruan dari berbagai sumber untuk mendapatkan publikasi real-time. Dan admin konsol memungkinkan Anda mengontrol dan pencarian teks lengkap untuk membuat query yang kompleks pada data mentah .

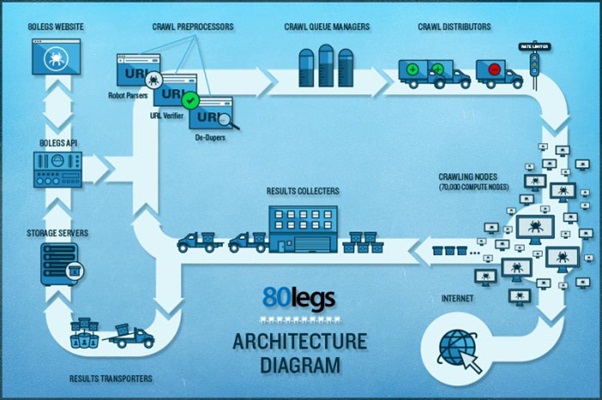

80legs adalah web scraping namun fleksibel yang kuat dan dapat dikonfigurasi dengan kebutuhan Anda. Mendukung untuk mengambil sejumlah besar data bersama dengan pilihan untuk men-download data yang diambil langsung.Web scraper mengklaim 600,000+ domain dan digunakan oleh pemain besar seperti MailChimp dan PayPal.

‘ Datafiniti ‘ memungkinkan Anda mencari seluruh data dengan cepat .80legs memberikan kinerja tinggi yang dengan cepat mengambil data yang dibutuhkan hanya dalam hitungan detik. Ia menawarkan rencana bebas untuk 10K URL dan dapat ditingkatkan untuk rencana intro sebesar $ 29 per bulan untuk 100K URL.

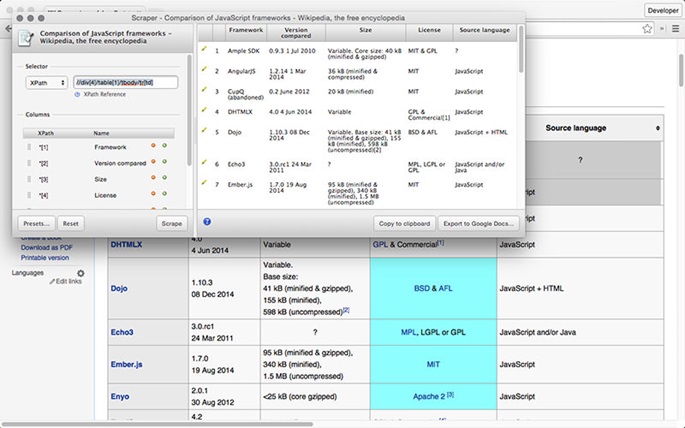

Scraper adalah ekstensi Chrome dengan fitur ekstraksi data terbatas tapi sangat membantu untuk membuat riset online, dan mengekspor data ke Google Spreadsheets . Alat ini ditujukan untuk pemula maupun ahli yang dapat dengan mudah menyalin data ke clipboard atau toko ke spreadsheet menggunakan OAuth.

Scraper adalah perangkat gratis, yang bekerja langsung di browser Anda dan auto-menghasilkan XPaths kecil untuk mendefinisikan URL. Itu tidak menawarkan kemudahan otomatis atau bot seperti Impor, Webhose dan lain-lain, tetapi juga manfaat bagi para pemula karena Anda tidak perlu untuk mengatasi konfigurasi berantakan .

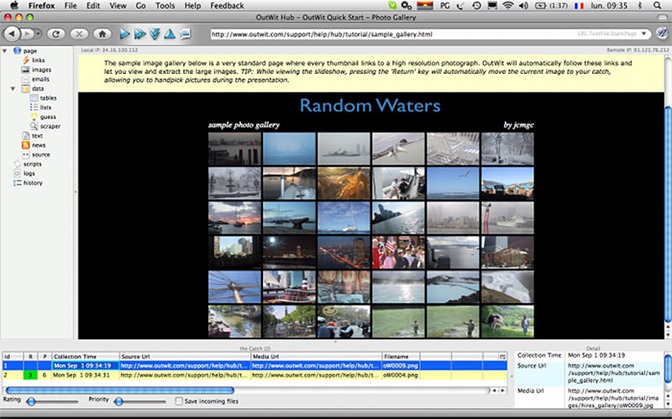

OutWit Hub adalah Firefox add-on dengan puluhan fitur ekstraksi data untuk menyederhanakan pencarian web Anda. Alat ini dapat secara otomatis menelusuri halaman dan menyimpan informasi yang diambil dalam format yang tepat. Mengecoh Hub menawarkan antarmuka tunggal untuk menggores kecil atau besar jumlah data per kebutuhan.

Mengecoh Hub memungkinkan Anda mengikis halaman web dari browser itu sendiri dan bahkan membuat agen otomatis untuk mengambil data dan format per pengaturan. Ini adalah salah satu web yang paling sederhana, yang bebas untuk menggunakan dan menawarkan kenyamanan untuk mengambil data web tanpa menulis satu baris kode.

Data apa yang Anda ingin mengekstrak dari Internet? Silahkan berbagi cerita dengan kami menggunakan bagian komentar di bawah ini.